Apple ARkitのアドバンテージは?

MediaPipeのFacemeshを使って、「・・・コレ大丈夫か?」と思ったのは事実。推定されたMesh位置情報を高速でサンプルして描画すると、激しいノイズが。メッシュの推定がブレているということだ(見た目にもそんな予感はしていた)。顔の姿勢取得も苦労したが、そもそも2/15の記事で、ARkitの方は眼球の姿勢がとれていた(当然顔の姿勢もとれるだろう)。

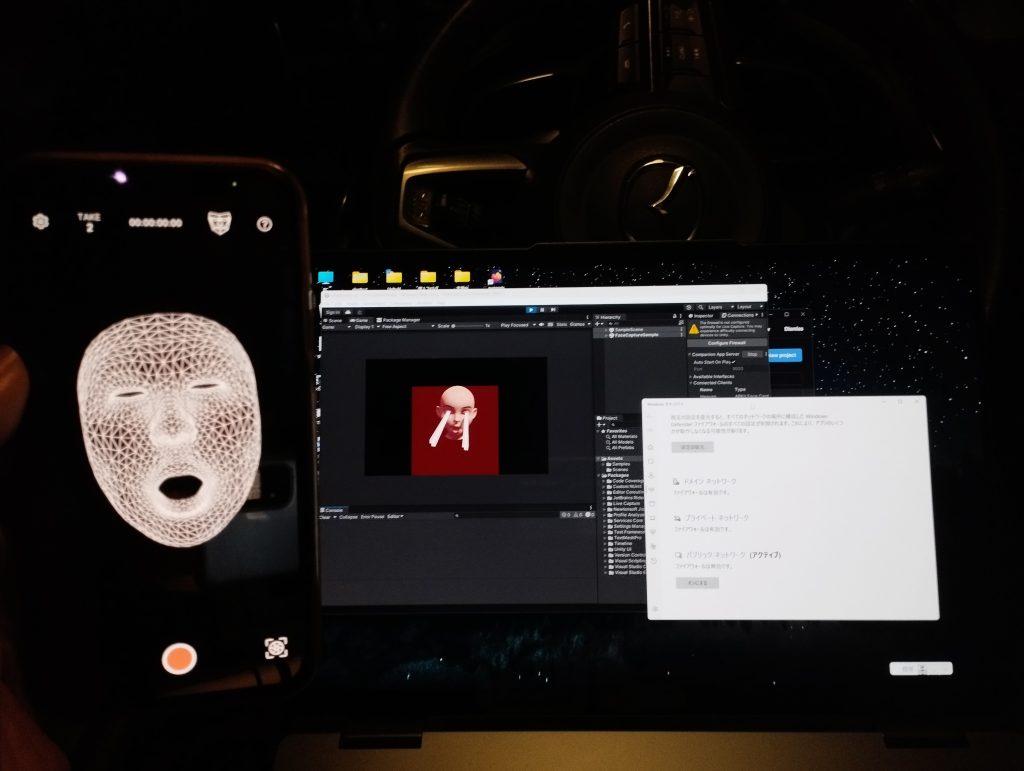

改めてARkitの顔認識をよく見ると、(こんなに暗いのに)ものすごくピッタリ推定できており、口の動作もほとんど完璧だ(Mediapipeは横向くと推定が怪しくなり、口も勝手に開いたりする)。google vs apple、IT界の両雄が作る似たサービス、同じくらいのクオリティがあると思ったら間違いで、おそらくこれに関してはARkitの圧勝だ。・・・自分は今、岐路に立たされている。Appleの軍門に下る事(あるいはApple製品を新たに購入するコスト)を避け、Mediapipeで実装すると、AIによる顔認識研究のクオリティは下がり、僕の評判も悪くなるだろう。「ここは買っとけ、iPad買っとけ!」・・・私のゴーストがそう囁くので、ケチケチせずiPadを2つ購入しようと思う。今、AI非接触計測の経験値を高めておけば、きっと何十倍にもなって返ってくる(ハズ)。このような実践で鍛えられた「◯◯のような用途にはこのAIが使える」といった細かな経験値が、今後数年はモノを言う気がする。

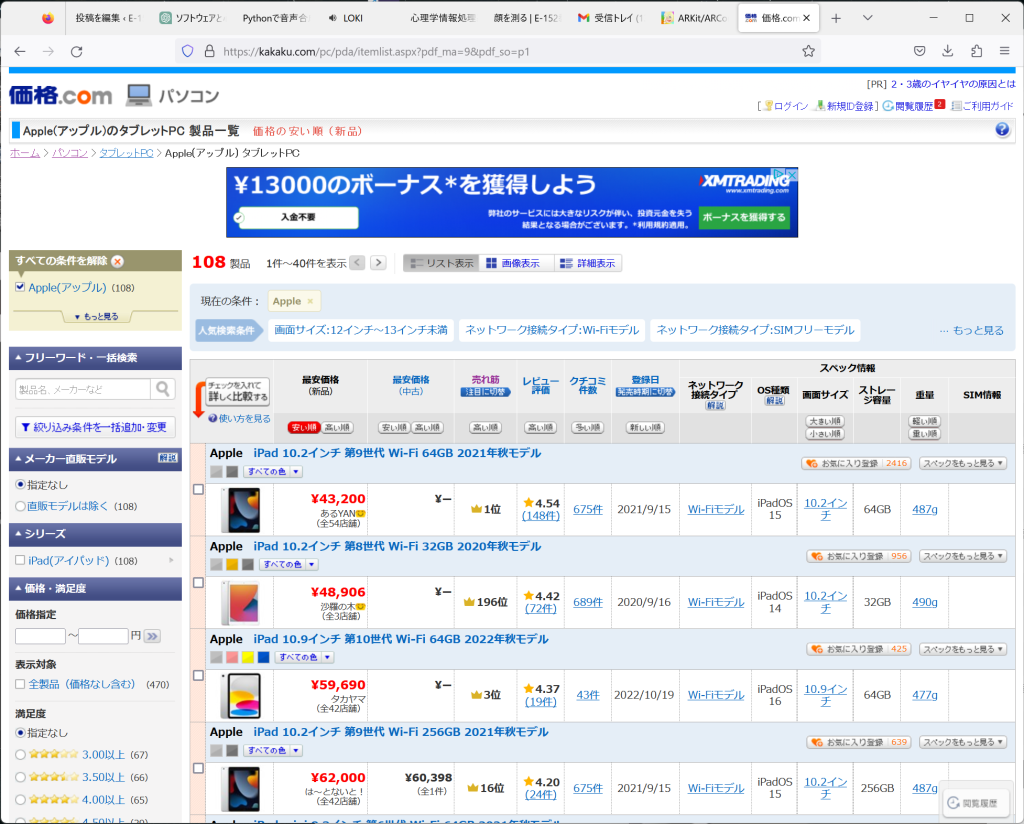

iPadのARkit対応状況はこちらのサイトにまとめられている。2019年のモデルあたりから使えるみたいだけれど一番安いのはどれかな。iPad Proは高機能だけれど2つ買うのは絶対嫌だし、ひょっとして2021年モデル(64GB)が43000円というのは、「買い」なのではないだろうか!?自腹なら中古でiPhoneという手もあるが、\24800のいつ壊れるかわからないXsを購入するのは危険に思える(実際壊れたXsが手元にひとつあるわけだし)。

Blendshapeを取得する

そして確認されるBlendshape。これはあくまでBlendshape値なので、顔の動きそのものではないが、運用上はこのほうが都合が良い。お笑いを見せて、一番動きが大きなBlendshapeを笑いの評価に使うとか。。。大頬骨筋に比べると、皺眉筋の動作検出は弱いように思える。用途の問題なのか、そもそも動く量が少ないからか。数値的にはEMGのアドバンテージは確定的にも思えるが・・・。

皺眉筋、大頬骨筋、上唇挙筋などに対応したブレンドシェイプがあるように思える。いろいろな動画刺激に対して、これで感情評価を行えば良い。ipadをどう固定するか考えないとね。