研究の概要

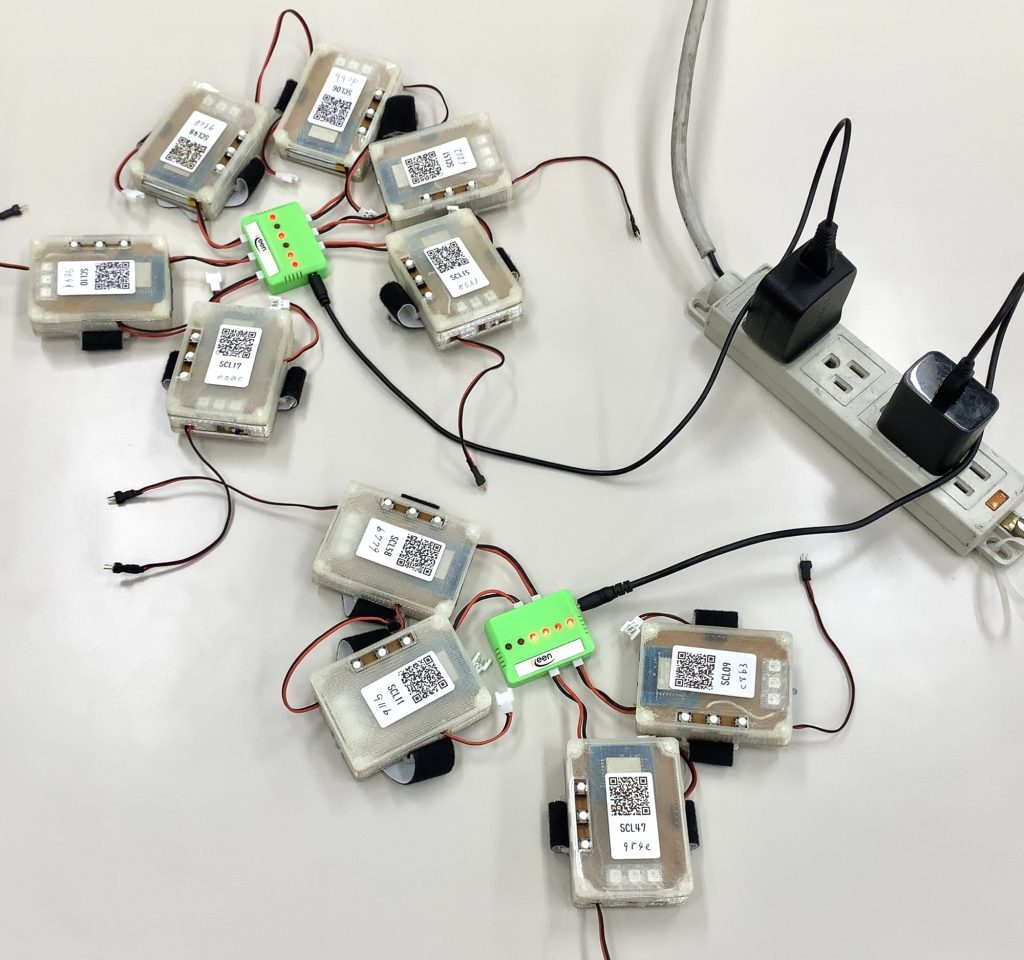

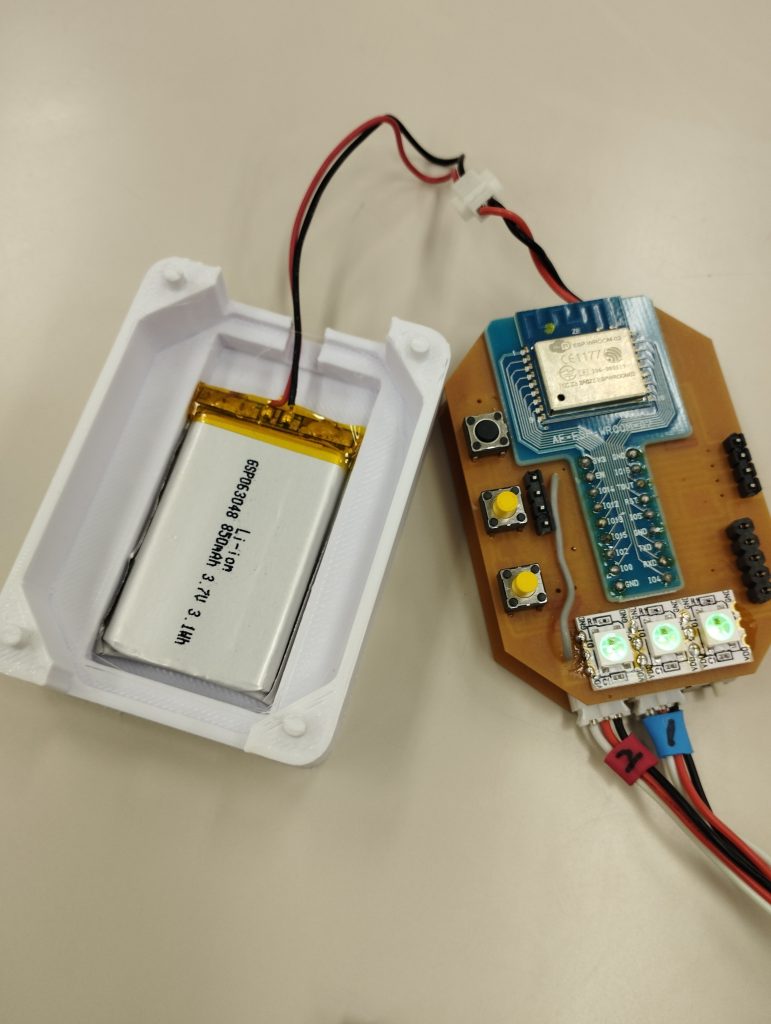

本研究では、知的障害者の表情、身体活動の測定を想定し、AIによる非接触計測の可能性を検討した。ソフトウェア環境は、様々なハードウェアでアプリケーションを作成可能なことを重視しゲームエンジンUnityを用いた。主に検討した環境は、1)Unity+Barracuda、2)Unity+OpenCV、3)Unity+Apple ARKitの3種類であった。ここでは、1)Unity+Barracuda環境における検討を概説する。

Unity+Barracuda環境を用いた非接触計測

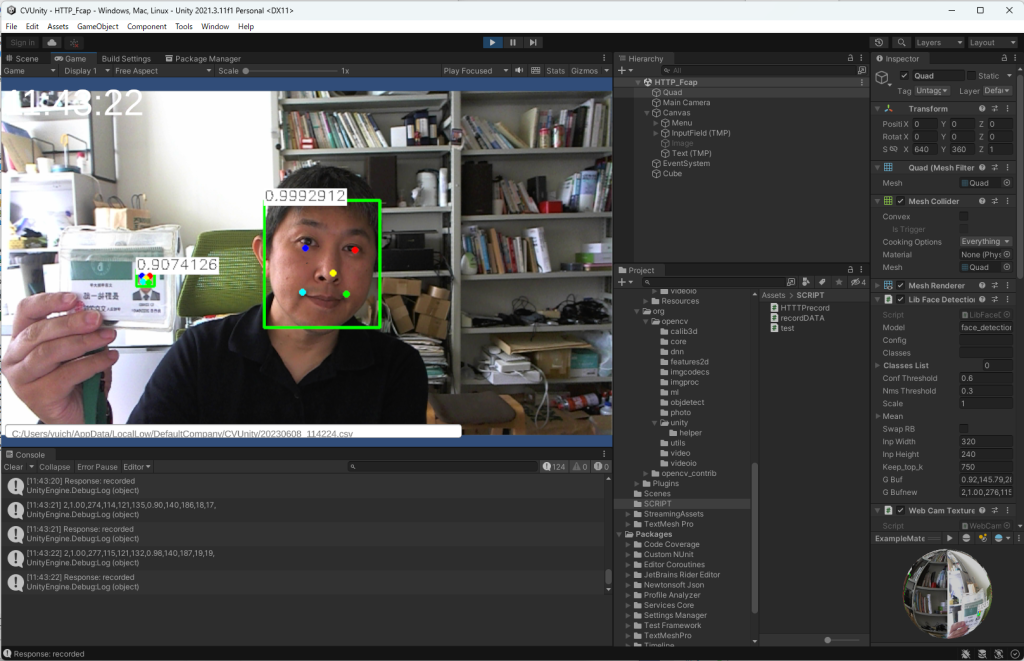

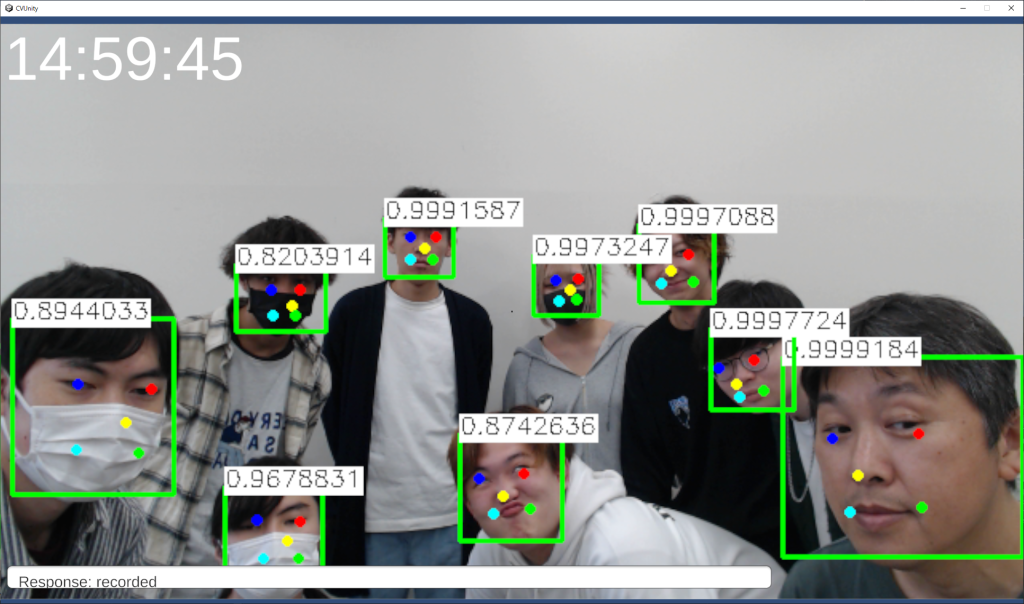

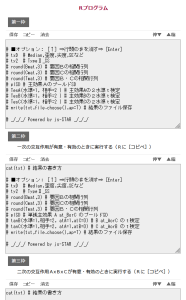

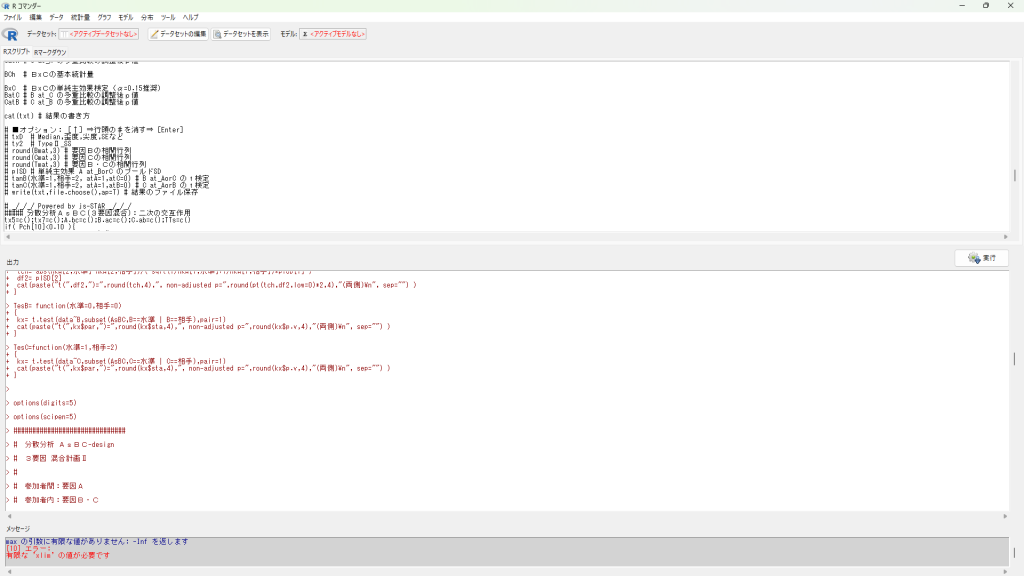

Barracudaは、Unity Technologiesが開発したニューラルネットワーク推論ライブラリ。ONNXフォーマットのモデルをインポートすることで、開発者はUnityプロジェクトに機械学習モデルを簡単に統合し、リアルタイムでの予測やインタラクションを実現できる。本研究では、身体活動測定用にgoogleのBodypixを、表情測定用に同じくgoogleのFaceMeshを、Barracuda環境で検証した。Barracudaで利用可能なONNXモデルに関しては、UnityTechnology高橋啓治郎氏のリポジトリにまとめられている。

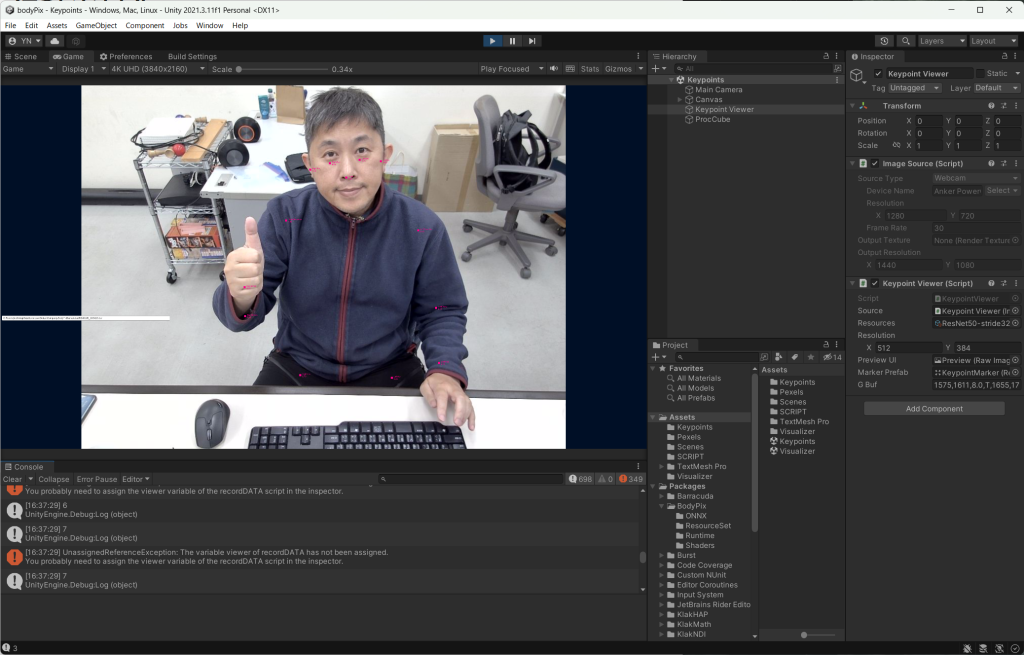

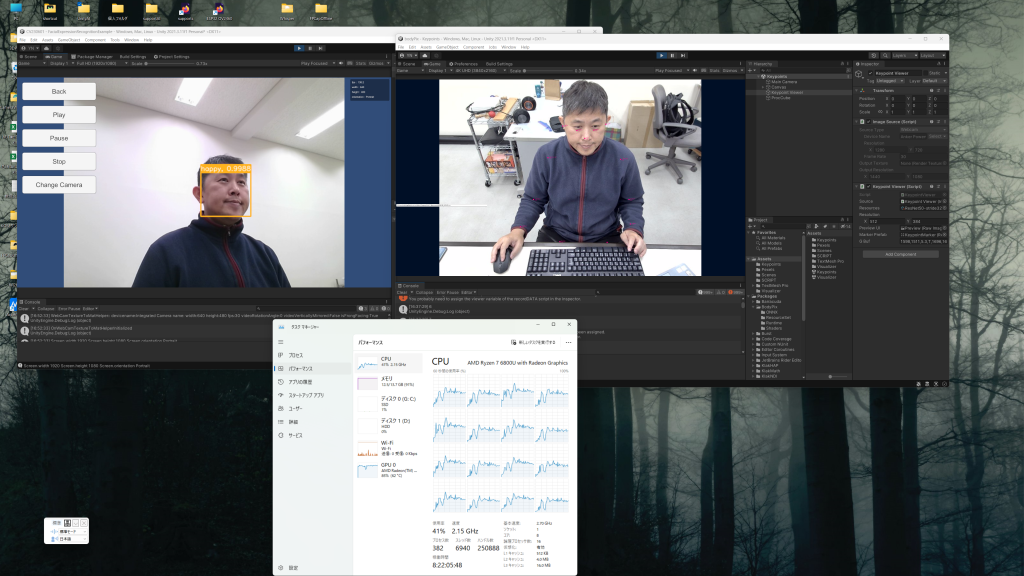

Bodypix

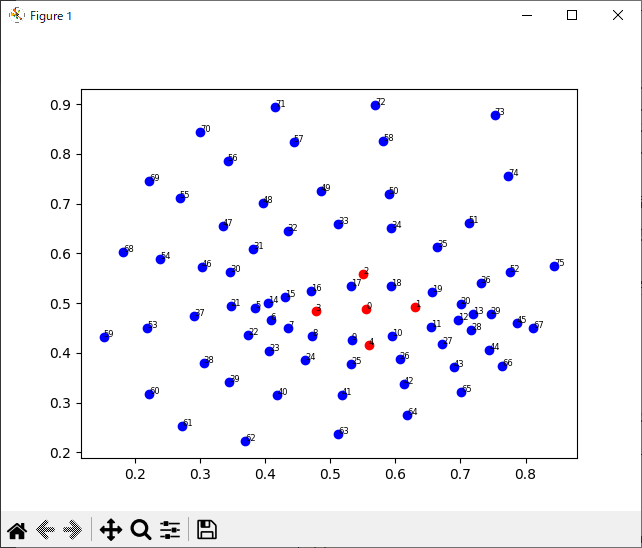

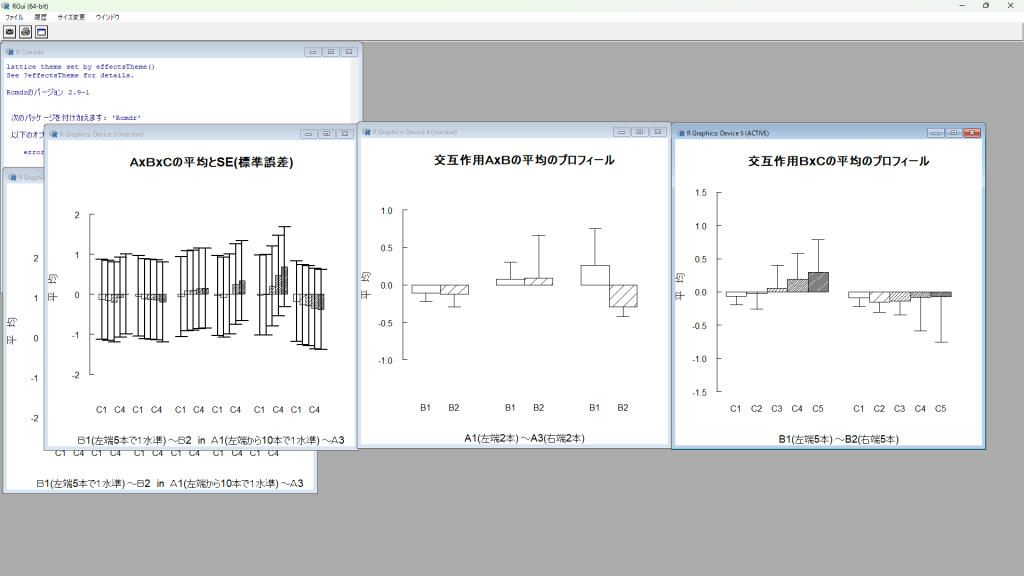

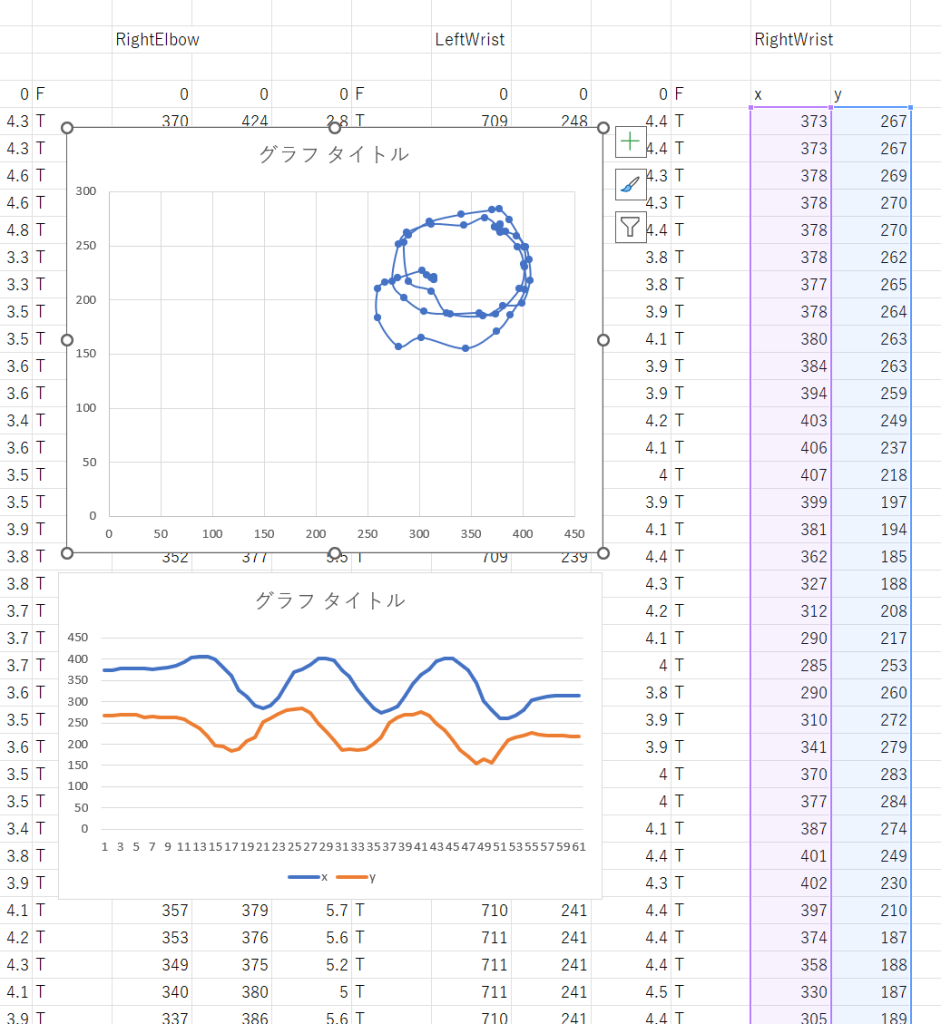

BodyPixはリアルタイム人体部位セグメンテーションを目的に作成されたニューラルネットであり、ポーズ推定や動作追跡などの機能をもっており、インタラクティブアプリケーションや仮想現実などの分野で用いられる。Unity+Barracuda環境では、Webカメラの映像をもとに、リアルタイムで主要な関節位置(2次元)を取得できる。関節位置の推定精度は、使用するONNX ファイルの規模に依存し、より大きなONNXファイルを用いることで高い精度での推定が可能になるが、そのぶん計算負荷も大きくなる。ある程度おおきな規模のONNXファイルを用いることで、安定した位置検出が可能であると考えられた。

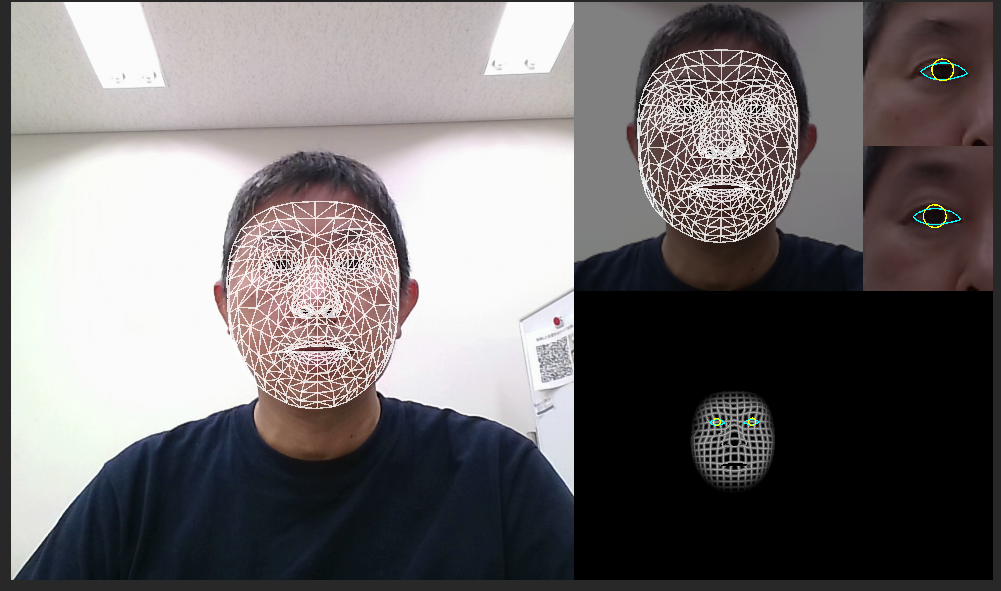

Face Mesh

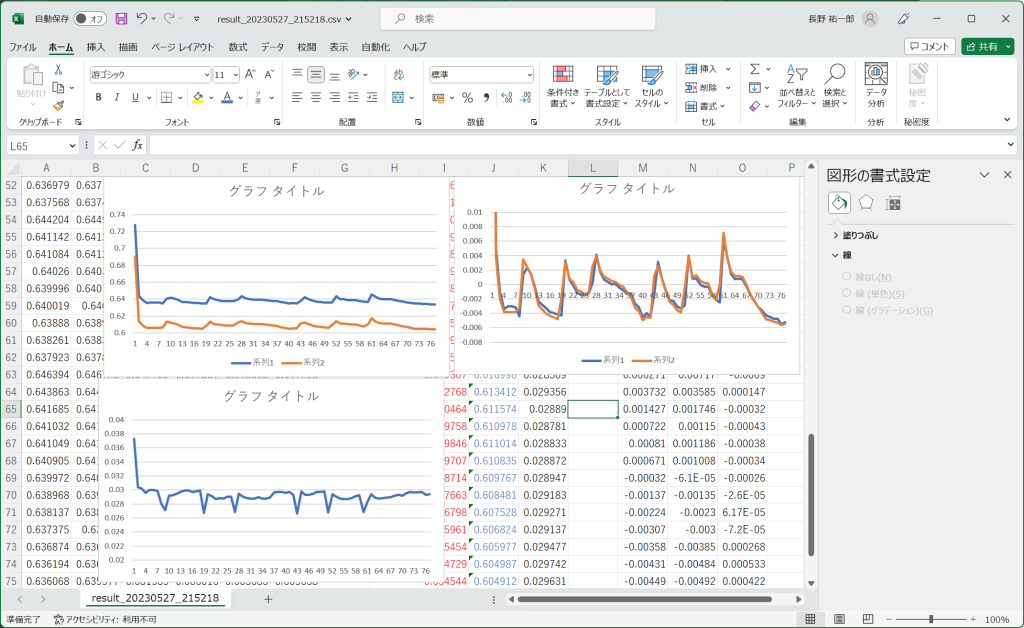

MediaPipe FaceMeshは、顔の高精度な3Dメッシュを生成することを目的に作成されたニューラルネットであり、顔のランドマーク検出や顔の表情分析などの機能をもっており、ARフィルターの作成やリアルタイムビデオ通話の顔の追跡などの用途で用いられる。Webカメラの映像をもとに、約450ポイントの顔ランドマークを推定できる。高橋啓治郎氏のリポジトリFaceMeshBarracudaでは、FaceMeshのに加え、目の動きを検出するAIが統合されており、目部分を抽出して瞼の動きを検出ことで、より正確な瞬目行動が可能となることが確認された。一方で、FaceMeshは安価なウェブカメラを使って顔のランドマークを推定できる利点はあるものの、顔が横を向いた際に精度が低くなる傾向が認められた。